Vous pouvez utiliser le SDK Vertex AI pour Python pour afficher les données d'exécution de test Vertex AI et comparer les exécutions.

La console Google Cloud fournit une visualisation des données associées à ces exécutions.

Obtenir les données des exécutions de test

Ces exemples impliquent l'obtention de métriques d'exécution, de paramètres d'exécution, de métriques de séries d'exécution, d'artefacts et de métriques de classification pour une exécution de test particulière.

Métriques récapitulatives

Python

run_name: spécifiez le nom d'exécution approprié pour cette session.experiment: nom ou instance de ce test. Vous trouverez la liste de vos tests dans la console Google Cloud en sélectionnant Tests dans le menu de navigation.project: l'ID de votre projet. Vous le trouverez sur la page d'accueil de la console Google Cloud.location: consultez la liste des emplacements disponibles.

Paramètres

Python

run_name: spécifiez le nom d'exécution approprié pour cette session.experiment: nom ou instance de ce test. Vous trouverez la liste de vos tests dans la console Google Cloud en sélectionnant Tests dans le menu de navigation.project: l'ID de votre projet. Vous le trouverez sur la page d'accueil de la console Google Cloud.location: consultez la liste des emplacements disponibles.

Métriques de séries temporelles

Python

run_name: spécifiez le nom d'exécution approprié pour cette session.experiment: nom ou instance de ce test. Vous trouverez la liste de vos tests dans la console Google Cloud en sélectionnant Tests dans le menu de navigation.project: l'ID de votre projet. Vous le trouverez sur la page d'accueil de la console Google Cloud.location: consultez la liste des emplacements disponibles.

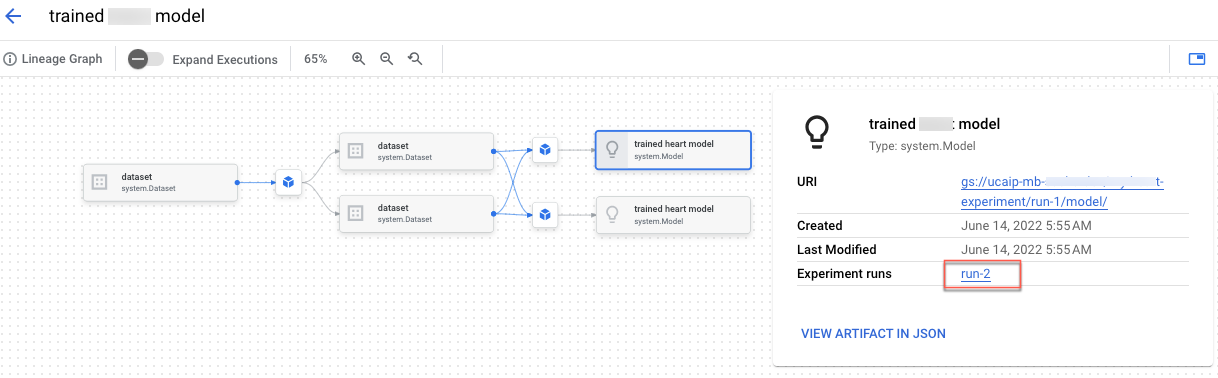

Artefacts

Python

run_name: spécifiez le nom d'exécution approprié pour cette session.experiment: nom ou instance de ce test. Vous trouverez la liste de vos tests dans la console Google Cloud en sélectionnant Tests dans le menu de navigation.project: l'ID de votre projet. Vous le trouverez sur la page d'accueil de la console Google Cloud.location: consultez la liste des emplacements disponibles.

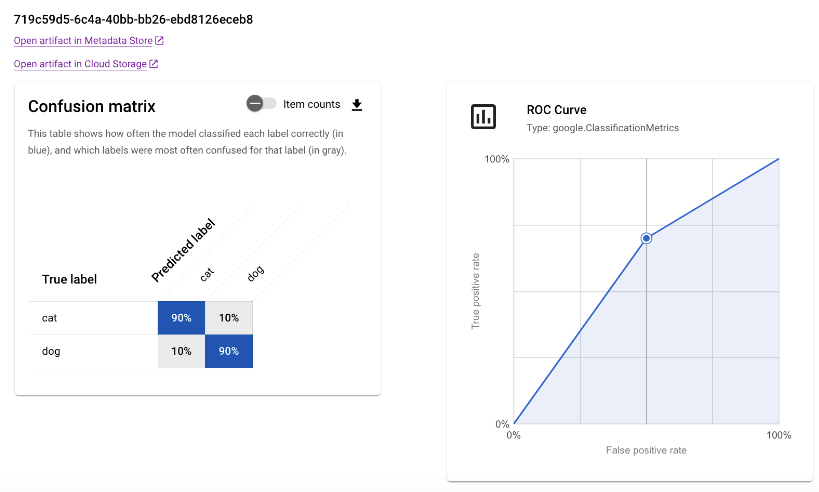

Métriques de classification

Python

run_name: spécifiez le nom d'exécution approprié pour cette session.experiment: nom ou instance de ce test. Vous trouverez la liste de vos tests dans la console Google Cloud en sélectionnant Tests dans le menu de navigation.project: l'ID de votre projet. Vous le trouverez sur la page d'accueil de la console Google Cloud.location: consultez la liste des emplacements disponibles.

Compare runs

À l'aide du SDK Vertex AI pour Python, vous pouvez récupérer les données associées à votre test. Les données pour les exécutions de test sont renvoyées dans un DataFrame.

Compare runs

Les données pour les exécutions de test sont renvoyées dans un DataFrame.

Python

experiment_name: indiquez le nom du test. Pour trouver la liste des tests dans la console Google Cloud, sélectionnez Tests dans le menu de navigationproject: l'ID de votre projet. Vous pouvez trouver ces ID sur la page d'accueil de la console Google Cloud.location: consultez la liste des emplacements disponibles.

Console Google Cloud

Utilisez la console Google Cloud pour afficher les détails de vos exécutions de test et comparer les exécutions de test entre elles.

Afficher les données des exécutions de test

- Dans la console Google Cloud, accédez à la page Tests.

Accéder à Tests

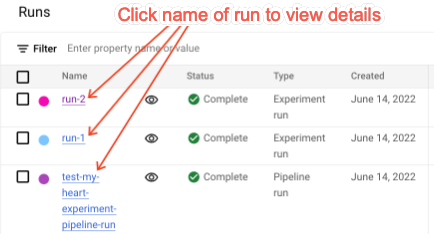

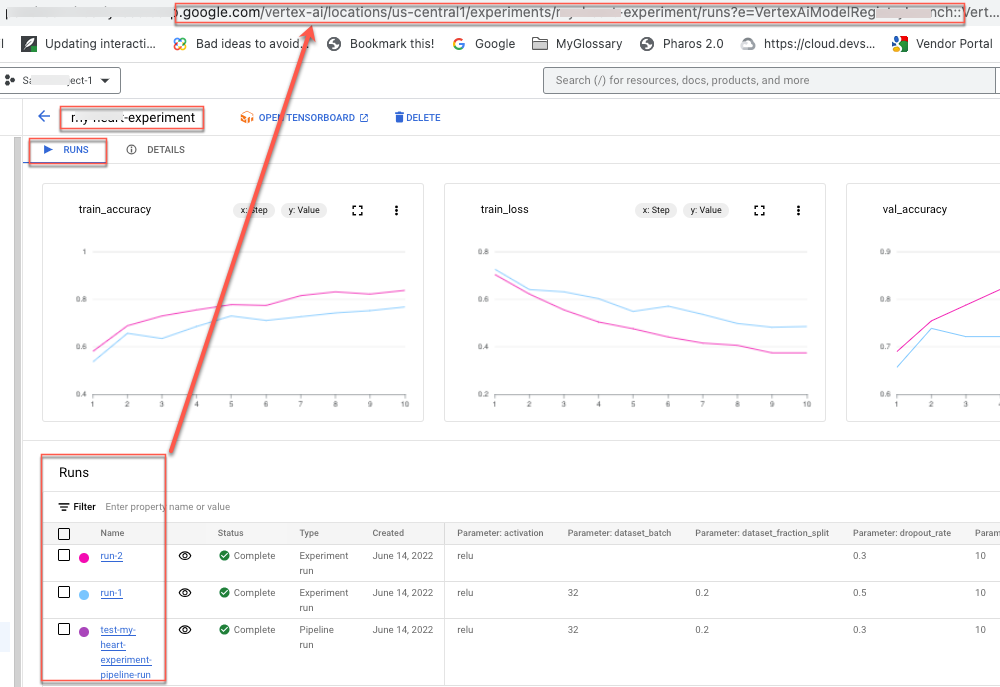

La liste des tests associés à un projet s'affiche. - Sélectionnez le test contenant l'exécution que vous souhaitez vérifier.

Une liste d'exécutions, de graphiques de données de séries temporelles, ainsi qu'une table de données de métriques et de paramètres s'affiche. Dans ce cas, remarquez que trois exécutions sont sélectionnées, mais que deux lignes seulement apparaissent dans les graphiques de données de séries temporelles. Il n'y a pas de troisième ligne, car la troisième exécution de test ne comporte aucune donnée de séries temporelles à afficher.

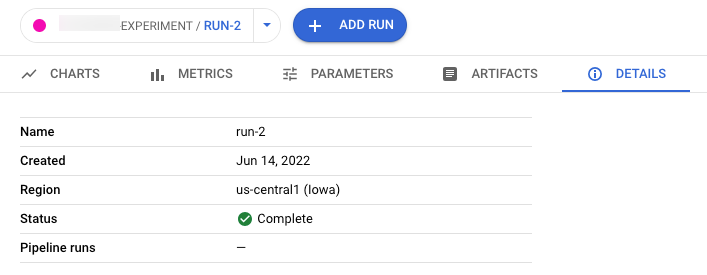

- Cliquez sur le nom de l'exécution pour accéder à sa page d'informations.

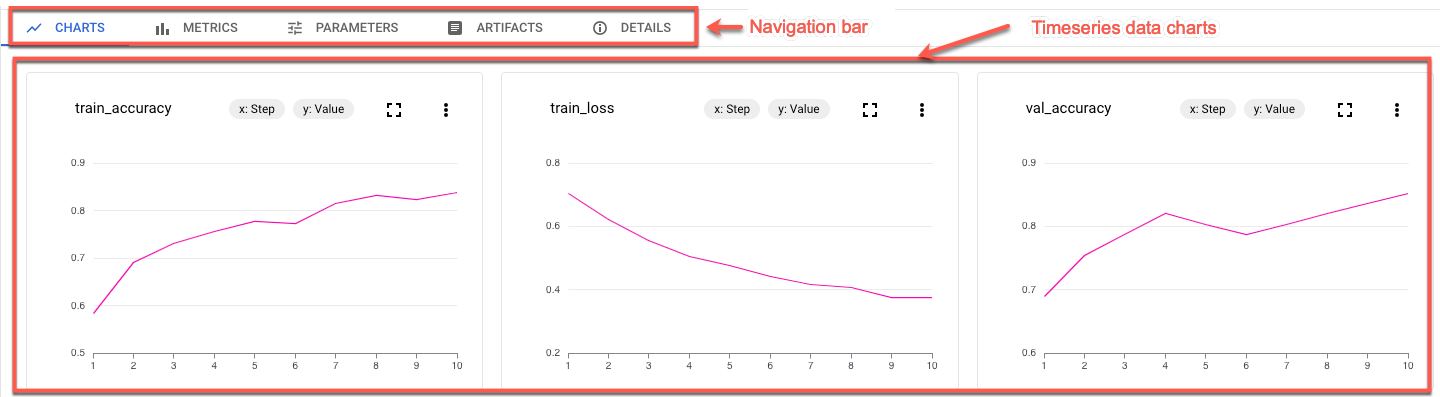

La barre de navigation et les graphiques de données de séries temporelles s'affichent.

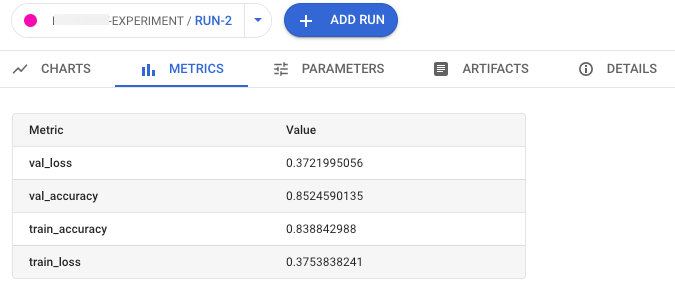

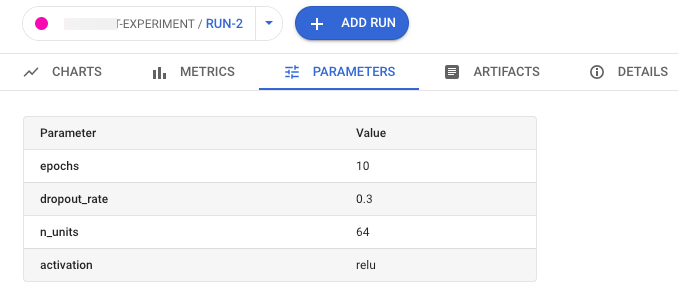

- Pour afficher les métriques, les paramètres, les artefacts et les détails de l'exécution sélectionnée, cliquez sur les boutons correspondants dans la barre de navigation.

- Métriques

- Paramètres

- Artefacts

Pour afficher la traçabilité des artefacts, cliquez sur le lien Ouvrir l'artefact dans le magasin de métadonnées. Le graphique de traçabilité associé à l'exécution s'affiche.

- Détails

- Métriques

Pour partager les données avec d'autres utilisateurs, utilisez les URL associées aux vues. Par exemple, partagez la liste des exécutions de test associées à un test :

Comparer les exécutions de test

Vous pouvez sélectionner des exécutions à comparer à la fois dans un test et entre plusieurs tests.

- Dans la console Google Cloud, accédez à la page Tests.

Accéder à Tests

La liste des tests s'affiche. - Sélectionnez le test contenant les exécutions que vous souhaitez comparer. La liste des exécutions s'affiche.

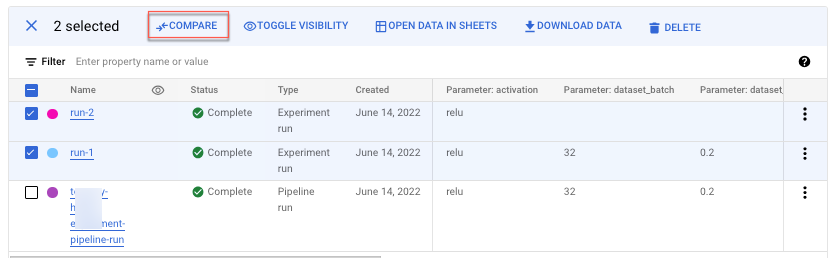

- Sélectionnez les exécutions de test que vous souhaitez comparer. Cliquez sur Comparer.

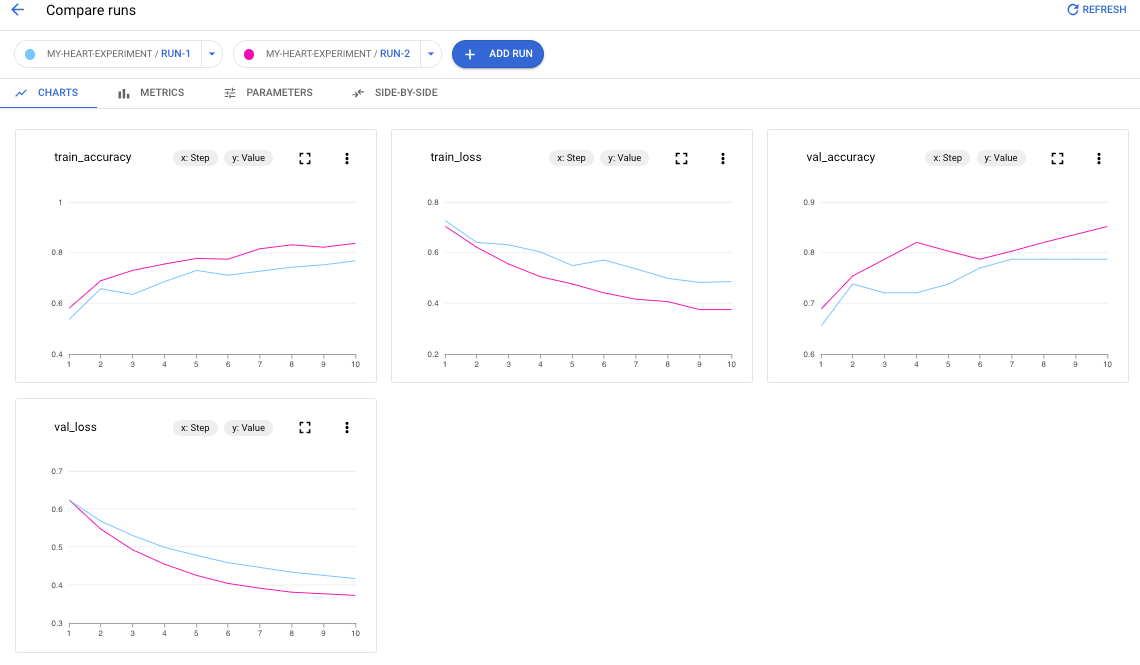

Par défaut, des graphiques s'affichent, comparant les métriques de séries temporelles des exécutions de test sélectionnées.

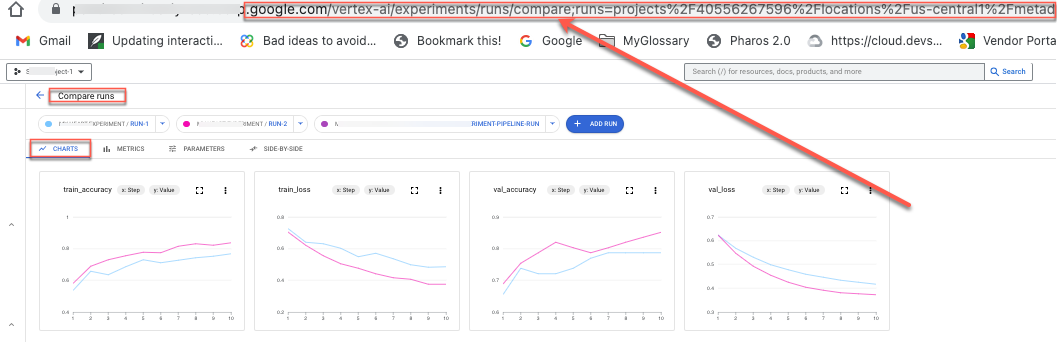

- Pour ajouter des exécutions supplémentaires à partir de n'importe quel test de votre projet, cliquez sur Ajouter une exécution.

Pour partager les données avec d'autres utilisateurs, utilisez les URL associées aux vues. Par exemple, partagez la vue comparative des données de métriques de séries temporelles :

Consultez la section Créer et gérer des exécutions de tests pour savoir comment mettre à jour l'état d'une exécution.